L’électron est un corpuscule qui joue un rôle fondamental dans toutes les branches de la Science et dans notre vie quotidienne. Sa découverte en 1897, par le Physicien anglais Joseph John Thomson marque un tournant dans notre compréhension de la nature. Elle précèdera de peu celle de la radioactivité.

Thomson essayait de comprendre la nature des rayons cathodiques, des rayons qui étaient émis par la cathode des “tubes à rayons cathodiques”, les ancêtres de nos télévisions avant l’arrivée des écrans plats.

De ces observations, Thomson déduisit la nature corpusculaire des rayons cathodiques. Il mesura le rapport de la masse et la charge de ces corpuscules et en déduisit qu’ils étaient au moins 1000 fois plus légers que l’ion d’hydrogène (le proton), l’objet le plus léger alors connu.

Dans le tube à rayons cathodiques de Thomson, le vide a été fait. La cathode (C )est à un potentiel négatif de quelques centaines de volts, l’anode étant reliée à la terre. Les rayons se dirigent vers l’anode et traversent deux fentes S pour frapper en ligne droite l’extrémité du tube au point O. En appliquant un champ électrique entre les deux plaques P1 et P2 les rayons cathodiques étaient déviés vers le haut selon le chemin indiqué en rouge. Un champ magnétique appliqué avec une bobine, déviait également les rayons cathodiques. De ces observations, Thomson déduisit la nature corpusculaire des rayons cathodiques.

L’électron est encore plus léger que ne l’avait mesuré Thomson : sa masse n’est que le mille huit cent trente septième de celle d’un proton. Le cortège atomique des électrons pèse encore moins lourd par rapport au noyau de l’atome qui est alourdi de neutrons. Les physiciens nucléaires préfèrent utiliser, plutôt les masses qui sont infinitésimales mesurées en grammes, les énergies de masse. L’énergie de masse mc² de l’électron (sa masse multipliée par la vitesse de la lumière au carré) vaut 511 keV.

La charge électrique de l’électron est la plus petite charge électrique connue. Par définition elle est négative. Sa valeur est notée e. Toutes les charges électriques, hormis celles des quarks, sont des multiples de cette charge e considérée comme élémentaire.

L’électron est un constituant élémentaire de la matière comme les quarks appelés up et down, les constituants des protons et neutrons. Il appartient avec ces derniers et le “neutrino électron” à la première génération des constituants fondamentaux de la matière. Il est le seul à pouvoir être observé facilement, les quarks étant confinés dans les noyaux et les neutrinos quasi impossibles à détecter.

L’électron, comme les quarks et le neutrino constituent les plus petites toupies que l’on puisse imaginer. Ils possèdent deux états de rotation possibles ou spin, l’intensité de cette rotation étant unique et la plus petite que l’on connaisse. Le grand physicien italien Enrico Fermi a formulé le premier la théorie de ces corpuscules à deux états de rotation comme l’électron, mais aussi les quarks, les protons et neutrons. Ils sont appelés fermions en son honneur.

Les fermions sont soumis à une règle appelée le principe d’exclusion de Pauli. Le principe de Pauli dit que deux électrons ne peuvent être dans un même état (appelé quantique). Il joue un très grand rôle dans l’atome. Sans lui, le cortège des électrons, attirés par sa charge électrique, s’écraseraient sur le noyau.

Selon le principe de Pauli, deux électrons seulement peuvent partager l’espace le plus proche du noyau, l’un tournant dans un sens, l’autre dans le sens opposé, car ils sont distingués par leur sens de rotation. Un troisième électron, ne pourra partager cet espace, car les deux états de spin sont pris. Il devra choisir un territoire plus éloigné. Ce territoire plus éloigné – que les atomistes appellent couche L – peut accueillir jusqu’à 8 électrons. Ainsi se contruisent, couche après couche, les atomes entourés du cortège électronique volumineux que nous connaissons.

Les électrons ne se contentent pas de transporter l’électricité. Ils sont présents partout, en physique, en chimie, en biologie. C’est en partageant les électrons périphériques de leurs cortèges que les atomes s’assemblent en molécules. Toute la chimie ou presque est affaire d’électrons.

En radioactivité, l’électron intervient dans trois phénomènes, dont le principal est le premier :

– L’émission d’un électron du noyau, radioactivité bêta ;

– La capture d’un électron atomique par le noyau : la capture électronique ;

– L’éjection d’un électron du cortège atomique par un gamma issu du noyau : la conversion interne.

Le positron ou positon a été découvert en 1933 par le physicien américain Carl Anderson. Anderson étudiait les particules présentes dans le rayonnement cosmique avec l’aide d‘une chambre de Wilson ou chambre à brouillard. Quand une particule porteuse d’une charge électrique traversait la chambre, la vapeur se condensait en de fines gouttelettes le long de sa trajectoire. La trajectoire était ainsi visualisée. La présence du champ magnétique d’une bobine qui courbait les trajectoires permettait de déterminer le signe, positif ou négatif, de la charge électrique.

C.D. Anderson, Physical Review 43, 491 (1933).

C.D. Anderson, Physical Review 43, 491 (1933).Dans l’atome, la Nature a attribué un rôle on ne peut plus différent aux protons et électrons porteurs pourtant de la même charge électrique élémentaire +e ou -e. Le proton “positif” est confiné dans le noyau; L’électron “négatif” fait partie du cortège électronique qui circule autour du noyau. Il est 1837 fois plus légers. Pourquoi n’existerait-il pas dans la Nature des protons qui seraient négatifs et des électrons qui seraient positifs.

La découverte d’un électron positif par Anderson a constitué le premier indice de l’existence de ces particules aux propriétés symétriques ou inverses de celles de notre monde ordinaire. Elles font partie de ce que l’on appelle aujourd’hui l’antimatière.

Pour démontrer l’existence de l’antiproton, il fallut attendre le développement des grands accélérateurs de particules. En 1955, l’équipe d’Emilio Segré et d’Owen Chamberlain utilisant à cette fin, le nouvel accélérateur de Berkeley (Californie), le bévatron, prouva l’existence de l’antiproton, puis peu après celle de l’inverse du neutron, l’antineutron.

Le positon n’existe pas dans notre environnement. Si l’on se souvient de la relation d’Einstein E = M c² qui relie la masse à l’énergie, on peut produire un positon avec de l’énergie. Il faut au moins apporter son énergie de masse qui vaut 511 keV. Il faut aussi pour respecter l’équilibre entre matière et antimatière créer une particule de matière, soit un électron, soit un neutrino. Il faut enfin compenser la charge électrique positive apparue.

Un mode rare de désintégrations radioactives – appelées bêta-plus – produit des positons. Le positon est associé à un neutrino-électron que l’on ne voit pas. L’énergie est prélevée sur l’énergie libérée par la désintégration.

Un second processus est la production simultanée d’un électron et d’un positon lors de l’interaction d’un gamma d’énergie suffisante avec un noyau, la production de paires. Comme un électron est aussi produit, il faut ajouter 511 kev aux 511 kev nécessaires pour créer le positon. Le gamma doit avoir une énergie supérieure à 1022 keV. La production de paires joue un rôle marginal dans notre environnement. Lors des désintégrations radioactives, peu de gamma possèdent de telles énergies.

IN2P3

IN2P3La matière de notre monde comporte des milliards de milliards de milliards d’électrons. S’il ne circule pas dans le vide, le positon rencontre très vite un de ces électrons. Antiparticules l’un de l’autre, le positon et l’électron se détruisent mutuellement, s’annihilent. Deux gamma d’annihilations d’énergie égale sont émis dos à dos. Chacun emporte les 511 keV d’énergie de masse des deux corpuscules qui est ainsi restituée. Cette réaction d’annihilation très caractéristique est utilisée en médecine nucléaire pour le dépistage des cancers.

Circulant au milieu de ces ennemis que constituent pour lui les électrons, les positons sont quasiment absents de notre environnement. Il en va de même des antiprotons. Comment expliquer cette absence de l’antimatière autour de nous, alors qu’à l’échelle élémentaire chaque fois qu’un corpuscule est créé ou détruit, un anticorpuscule l’est aussi. Où est passé l’antimatière ? C’est un des grandes questions auxquelles doit répondre la physique des particules.

Des expériences ont mises en évidence que la symétrie entre particules et antiparticules n’était pas parfaite dans le cas des forces faibles qui sont à l’origine en particulier de la radioactivité bêta.

Cette asymétrie qui est minime peut-elle expliquer l’absence apparente de l’antimatière autour de nous ?

La conquête de l’espace nous a habitué aux mouvements d’un satellite autour de la Terre. A l’aide de fusée d’appoints, les techniciens peuvent faire varier à volonté son énergie et sa trajectoire d’un satellite et l’amener ainsi à suivre n’importe quelle autre orbite

L’électron qui tourne autour d’un noyau ne jouit pas de cette liberté. La nature lui impose un choix limité d’énergies, de la même façon que l’industrie impose aux mécaniciens une série de tailles de boulons : l’électron ne peut pas avoir n’importe quelle énergie. L’émission ou l’absorption de photons jouent le rôle des fusées d’appoint, en faisant sauter l’électron d’une « trajectoire » à une autre. Mais cette dernière ne peut qu’appartenir à une suite de trajectoires prédéfinies.

L’échelle microscopique est régie par la mécanique quantique. Il est préférable de parler de l’état d’un électron plutôt que de sa « trajectoire » : cet état est caractérisé par son énergie et la manière dont il occupe l’espace. Autour d’un noyau, le nombre d’états que peut occuper un électron est limité. On regroupe les différents états de même énergie sous le nom de « couches ». Les électrons d’un atome appartiennent à diverses couches caractérisées par une énergie. Ces couches sont appelés K, L, M, N… par les atomistes.

La couche K qui correspond à l’attraction la plus forte par le noyau est la première à se remplir. Deux électrons au maximum peuvent occuper cette couche. Un troisième électron n’y trouverait pas de place. Il doit se placer sur la couche suivante, la couche L, où il sera moins lié au noyau que les électrons de la couche K.

Les énergies de liaison des électrons sur les couches suivantes sont de plus en plus faibles. Quand une place devient disponible sur une couche, un électron situé sur une couche plus externe comble ce vide en sautant pour occuper la place laissée libre et être ainsi plus lié au noyau. Cette transition est accompagnée par l’émission d’un grain d’énergie « électromagnétique » qui hérite de la différence d’énergie de liaison entre les deux couches. Ces minuscules ondes électromagnétiques sont des photons dont certains – les photons lumineux – sont capables d’impressionner la rétine de l’œil.

L’énergie du photon est égale à la différence d’énergie des deux couches. L’énergie des couches étant caractéristiques de l’atome, celle du photon l’est aussi. La longueur d’onde de ce photon (c’est-à-dire sa couleur dans le cas de la lumière) étant reliée à son énergie, cette longueur d’onde est à son tour propre à l’atome.

La lumière et plus généralement les rayonnements émis sont donc caractéristiques de l’atome et du saut dans l’atome. Quand on analyse cette lumière par un prisme en fonction de la longueur d’onde, on observe une suite de raies, dont chacune correspond à un saut entre couches. Ces raies constituent une empreinte extraordinaire. Elles permettent d’identifier la présence d’hydrogène ou d’autres atomes, dans des planètes ou des étoiles situées à des années lumières.

Les noyaux sont a priori très différents des atomes. Cent mille fois plus petits, ils sont plus complexes. La matière nucléaire est compacte alors que l’espace atomique est essentiellement constitué de vide. Pourtant noyaux et atomes présentent des traits communs.

Quand le noyau se trouve dans un autre état, il dispose d’un supplément d’énergie. Il retourne à l’état normal (celui de repos maximum) et se débarrasse de son énergie d’excitation en émettant un photon d’énergie caractéristique, appelé photon γ ou gamma. Ces photons sont de même nature que les photons et rayons X émis par les atomes, mais leur énergie est beaucoup plus grande : couramment de l’ordre du million d’électronvolts (MeV).

Les états d’énergie de la communauté de nucléons assemblée en noyau sont variés. Tout d’abord, on observe, comme dans l’atome, l’existence de couches. Les énergies de liaison des nucléons du noyau ne peuvent prendre qu’une suite de valeurs imposées correspondant à autant de « couches ».

Par exemple, des configurations avec 2, 8, 20, 28, 50, 82, 126 nucléons d’une espèce confèrent une stabilité plus grande au noyau. Il y a analogie avec la stabilité des atomes de gaz rares dont la couche externe est complète. Ces nombres sont dits « magiques ».

Les noyaux sont également gouvernés par les lois de la mécanique quantique qui prennent le pas sur celles de la mécanique classique à l’échelle microscopique. Le noyau ne peut se retrouver que dans un nombre limité d’états. Ces « états » sont caractérisés en premier lieu par une énergie. L’état que le noyau finit par atteindre quand il est livré à lui-même est celui dont l’énergie est minimum : c’est l’état « fondamental ».

En plus de cette structure en couches, le noyau peut avoir des mouvements collectifs qui correspondent à de nouveaux états. Contrairement à l’atome où l’on peut considérer l’état d’un électron individuel (niveau d’énergie, état de rotation), pour un noyau on ne peut considérer que l’ensemble de ses nucléons.

Ainsi la communauté de nucléons peut entrer en vibration. Les énergies de ces vibrations ne peuvent prendre que des valeurs bien déterminées, en vertu de la mécanique quantique.

Enfin, le noyau n’est pas forcément sphérique, il peut se déformer et subir un mouvement de rotation collectif. Les énergies de ces états de rotation ne peuvent également prendre qu’une série de valeurs déterminées. On dit qu’elles sont quantifiées.

La contrepartie de l’extrême petitesse des atomes est leur très grand nombre. Dans un centimètre cube d’eau, il y a autant d’atomes d’oxygène et d’hydrogène que de gouttelettes d’eau dans la Méditerranée. Visiter l’atome, c’est en quelque sorte passer de l’échelle de la Méditerranée à celle d’une goutte d’eau.

Cette « multitude » est reflétée par la valeur du nombre d’Avogadro. Ce nombre, qui représente le nombre de molécules dans 18 g d’eau, ou d’atomes dans 56 grammes de fer, vaut N = 6,022 10 à la puissance 23 soit 602 mille milliards de milliards. Le nombre d’atomes présents dans le corps humain est environ 10 000 fois plus élevé. Il faut garder en mémoire ces multitudes faramineuses. Elles expliquent pourquoi, dans un corps radioactif, le nombre des noyaux qui se désintègrent à chaque instant est élevé alors que la proportion des noyaux qui subissent ces désintégrations reste infime.

Ci-dessus : Frances Arnold, George Smith et Sir Gregory Winter

Avec l’agriculture, les humains ont appris à sélectionner les plantes les plus nutritives et résistantes, et à les croiser au besoin pour augmenter encore leur rendement. Au fil des générations, ils ont ainsi peu à peu orienté l’évolution des plantes cultivées. Les trois lauréats du prix Nobel de chimie 2018 ont contribué à développer des outils pour diriger l’évolution de façon plus précise et rapide, en laboratoire.

En 1993, Frances Arnold, à l’institut de technologie de Californie, et ses collègues ont ainsi effectué la première évolution dirigée d’enzymes – des protéines qui catalysent les réactions chimiques dans les cellules – pour élargir leur rôle à des environnements inhabituels. Le principe de la méthode est simple :

1) choisissez une enzyme dont la fonction vous intéresse ;

2) construisez une bibliothèque de mutants de cette enzyme ;

3) placez ces mutants dans des conditions où votre enzyme de départ ne fonctionne habituellement pas ;

4) ne gardez que les mutants qui ont fonctionné dans ces conditions ;

5) recommencez à l’étape 2 jusqu’à obtenir la sélectivité recherchée.

En utilisant une technique qui recopie des séquences d’ADN en y introduisant des erreurs (mutagenèse aléatoire par PCR), Frances Arnold et ses collègues ont ainsi produit un variant particulièrement efficace de la subtilisine E, une enzyme qui coupe la caséine (une protéine du lait) : non seulement ce variant était capable d’agir dans un solvant où l’enzyme d’origine ne fonctionnait pas, mais il était 256 fois plus efficace que celle-ci.

Les années suivantes, Frances Arnold et ses collègues ont optimisé la technique. Ils se sont aperçus que certaines régions des enzymes étaient plus susceptibles de fournir une amélioration que d’autres. Ils ont aussi développé des méthodes pour produire des bibliothèques de mutants plus variés. Et ils ont prouvé l’efficacité de leur technique sur de multiples enzymes et pour de multiples conditions, comme divers solvants ou diverses températures. Ils ont ainsi produit, par exemple, une enzyme très efficace à la fois à basse et haute température. Ils ont même réussi à faire d’une fonction minoritaire d’une enzyme sa principale fonction, en sélectionnant d’abord des variants qui avaient perdu leur fonction majoritaire, puis, dans un deuxième temps, en sélectionnant de nouveaux variants dont la fonction minoritaire était renforcée.

Aujourd’hui, les enzymes produites par évolution dirigée sont couramment utilisées dans l’industrie pour produire nombre de molécules telles que des biocarburants, des détergents, des exhausteurs de goût ou des molécules pharmaceutiques. Nombre des enzymes optimisées par l’équipe de Frances Arnold en font partie.

L’autre technique récompensée, nommée phage display (exposition à la surface de bactériophages), est apparue quelques années plus tôt. En 1985, George Smith, à l’université du Missouri à Columbia, a mis au point une méthode qui lui a permis de produire un peptide à la surface de bactériophages (des virus de bactéries). À l’aide d’un anticorps conçu pour reconnaître ce peptide, il a ensuite pu attraper les bactériophages qui avaient bien produit le peptide.

Là aussi, le principe est simple et ingénieux : dans le génome du bactériophage, une partie code une protéine mineure de la surface du virus. George Smith y a inséré une séquence d’ADN codant un peptide (un fragment de protéine), puis il a infecté des bactéries avec les bactériophages ainsi modifiés. Les virus se sont alors reproduits, certains portant le peptide à leur surface, d’autres seulement des bouts (voire aucun) ou des versions mutées au gré de la reproduction. En venant à la pêche avec un anticorps spécifique du peptide collé à un support solide, George Smith a alors récupéré une population de bactériophages mille fois plus riche en peptide qu’avant la pêche.

Si cette technique est d’abord passée inaperçue, elle a montré tout son potentiel quelques années plus tard, quand diverses équipes, dont celle de George Smith, l’ont utilisée pour isoler, parmi une bibliothèque de molécules, de nouveaux peptides ou anticorps hautement spécifiques d’une situation donnée. Ces équipes ont commencé par constituer d’énormes bibliothèques de bactériophages produisant plusieurs millions de peptides différents, puis sont venus à la pêche via la technique du phage display. Ils ont ainsi récupéré des peptides spécifiques de leur « hameçon », ce qui leur a permis d’en déduire le motif qui leur conférait leur haute affinité à l’hameçon.

Dans les années 1990, notamment, Gregory Winter, à l’université de Cambridge, et ses collègues ont utilisé cette technique pour produire de nouveaux anticorps à visée thérapeutique. Tout d’abord, ils ont montré que le phage display fonctionnait lorsque l’on remplaçait le peptide par un bout d’anticorps humain, plus précisément l’extrémité impliquée dans la reconnaissance de sa cible : les bactériophages exprimaient bien le fragment d’anticorps à leur surface, et il était possible de pêcher ces bactériophages marqués. Puis les chercheurs ont constitué une grande bibliothèque de bactériophages produisant différents variants de ce fragment d’anticorps et sont venus à la pêche avec des protéines que l’on cherchait à cibler dans diverses pathologies. Et en appliquant plusieurs fois ce procédé, ils ont suffisamment affiné la sélection des anticorps pour produire une molécule thérapeutique, l’adalimumab, qui neutralise une protéine, TNF-alpha, impliquée dans le déclenchement de l’inflammation dans de nombreuses maladies auto-immunes.

Depuis, plusieurs anticorps ont été obtenus par cette méthode, notamment contre le lupus et contre la toxine bactérienne responsable de l’anthrax. Et des essais cliniques en cours sur de nombreux autres suggèrent que l’exploration est loin d’être finie.

Le prix Nobel de Chimie a été attribué, mercredi 4 octobre, au Suisse Jacques Dubochet, ancien chercheur de l’université de Lausanne, à l’Américain d’origine allemande Joachim Frank (université de Columbia) et au Britannique Richard Henderson (université de Cambridge) pour leurs travaux sur la cryo-microscopie électronique, qui a simplifié et amélioré l’imagerie des biomolécules. Jacques Dubochet est né en 1942 à Aigle, en Suisse, Joachim Frank, en 1940 à Siegen, en Allemagne, et Richard Henderson en 1945 à Edimbourg.

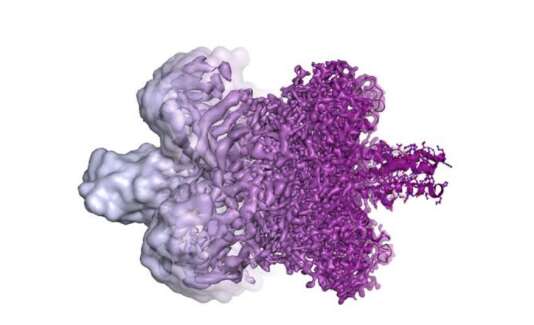

Représentation d’une enzyme obtenue par cryo-microscopie électronique avec une résolution croissante de la gauche vers la droite

« Cette méthode a fait entrer la biochimie dans une nouvelle ère », souligne l’Académie royale des sciences dans un communiqué. « Les chercheurs peuvent désormais visualiser des processus qu’ils n’avaient jamais vu auparavant, ce qui est décisif tant pour la compréhension fondamentale de la chimie de la vie que pour le développement de médicaments. »

On a longtemps cru que la microscopie électronique était réservée à la matière inerte : le bombardement d’électrons était susceptible d’endommager les molécules du vivant, tandis que le vide faisait s’évaporer l’eau qui est leur milieu « naturel ». Autre inconvénient : la microscopie électronique ne livrait que des images floues, en deux dimensions. Les lauréats font partie d’une longue lignée de scientifiques qui se sont ingéniés à changer la donne.

L’eau contenue dans les échantillons refroidie quasi instantanément

En 1990, Richard Henderson est parvenu à générer une image en trois dimensions d’une protéine, avec une résolution atomique. Il avait été aidé en cela par les travaux de Joachim Franck: entre 1975 et 1986, celui-ci avait développé des méthodes de traitement d’image permettant de fusionner une série d’images en deux dimensions pour obtenir une structure fine en trois dimensions.

Le mérite de Jacques Dubochet a ensuite été d’introduire l’eau dans la microscopie électronique, au début des années 1980. Il est parvenu à refroidir quasi instantanément l’eau contenue dans les échantillons, afin qu’elle soit vitrifiée, et non cristallisée – ce qui nuit à la visualisation des structures observées. Les molécules ainsi emprisonnées pouvaient alors être saisies « sur le vif », dans différentes configurations « naturelles ».

Depuis ces travaux, la technique de cryo-microscopie n’a fait que s’affiner, permettant d’accéder à des biomolécules toujours plus petites – au point de concurrencer en précision, voire de surpasser en commodité d’utilisation, les lignes de rayons X des synchrotrons. L’un des succès récents dans ce domaine a été la détermination de la structure tridimensionnelle de l’hémoglobine.

Mais la structure du virus Zika, ou de protéines à l’origine de la résistance des bactéries aux antibiotiques, font aussi partie d’images récentes: « la biochimie fait désormais l’objet d’une développement explosif et est prête pour un avenir excitant », se réjouit le comité Nobel dans son communiqué.